- +90 216 455-1865

- info@compecta.com

All-In-One & sofort einsatzbereit

CompecTA SuperNova Engine™ ist eine superschnelle und energieeffiziente Serverlösung für Deep Learning- und KI-Anforderungen.

Entwickelt mit der weltbesten Hardware-, Software- und Systemtechnik und jahrelanger Erfahrung von CompecTA HPC Solutions.

Deep Learning Neural Network-Bibliotheken, Deep Learning Frameworks, Betriebssystem und Treiber sind vorinstalliert und sofort einsatzbereit.

Enterprise Level Support

CompecTA SuperNova Engine™ wird mit einem Enterprise Level Support-Paket von HPC-Experten mit über 20 Jahren Erfahrung auf diesem Gebiet geliefert.

Wir helfen Ihnen bei allen Problemen, die mit Ihrem System auftreten können.

Freie CPU-Zeit

CompecTA SuperNova Engine™ verfügt über 100.000 Stunden CPU-Zeit auf CompecTAs internem HPC-Cluster-Service namens FeynmanGrid™.

Nutzen Sie diese Gelegenheit, um Erfahrungen mit der Verwendung von HPC-Clustern zu sammeln, die Leistung einer beliebigen Anwendung zu testen oder einen neuen Code/eine neue Anwendung zu testen.

CompecTA SuperNova™ Serie

Superschnelle und skalierbare KI-Serversysteme

SuperNova Engine™ A30 BELIEBT

660 TFLOPS of Tensor Performance

41.2 TFLOPS of FP32 Performance

20.8 TFLOPS of FP64 Performance

1,320 TOPS of INT8 Tensor Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Schnelles Training für neuronale Netze

Schnelle Schlussfolgerung

Preise ab

$38,995 (Ohne Steuer)

CNVAIS1-A30V1

- 19" 1U Rackmount Chassis 4-way PCIe GPUs

- Dual INTEL Xeon CPUs (up to 64-Cores)

- 512 GB DDR4 3200MHz ECC Memory (up to 2TB)

- 4 x NVIDIA A30 24GB HBM2 Memory @ 933GB/s 165W

- 15,216 Total CUDA® Cores

- 896 Total Tensor Cores

- Up to 16 MIGs (Multi Instance GPUs) at 6GB each

- 2 x 1.92TB NVMe Disks

(up to 4 disks) - Ubuntu Linux 20.04 / 22.04 LTS

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- Anaconda Data Science Platform

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Infiniband HDR 200Gb/s Network for multi-node GPU Direct RDMA support

SuperNova Engine™ A100 AM BESTEN

1,248 TFLOPS of Tensor Performance

78 TFLOPS of FP32 Performance

38.8 TFLOPS of FP64 Performance

2,496 TOPS of INT8 Tensor Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Superschnelle Schlussfolgerung

Preise ab

$79,495 (Ohne Steuer)

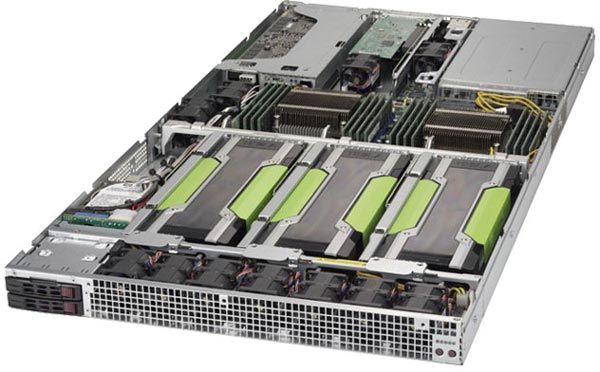

CNVAIS1-A100V2

- 19" 1U Rackmount Chassis 4-way PCIe GPUs

- Dual INTEL Xeon CPUs (up to 64-Cores)

- 1 TB DDR4 3200MHz ECC Memory (up to 2TB)

- 4 x NVIDIA A100 80GB HBM2 Memory @ 1935GB/s 300W

- 27,648 Total CUDA® Cores

- 1,728 Total Tensor Cores

- Up to 28 MIGs (Multi Instance GPUs) at 10GB each

- 2 x 1.92TB NVMe Disks

(up to 4 disks) - Ubuntu Linux 20.04 / 22.04 LTS

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- Anaconda Data Science Platform

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Infiniband HDR 200Gb/s Network for multi-node GPU Direct RDMA support

SuperNova Engine™ NA104 with NVLINK

1,248 TFLOPS of Tensor Performance

78 TFLOPS of FP32 Performance

38.8 TFLOPS of FP64 Performance

2,496 TOPS of INT8 Tensor Performance

Am besten geeignet für:

Super-fast Multi-GPU Workloads

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Superschnelle Schlussfolgerung

Fordern Sie ein Angebot an

CNVAIS1-NA104V2

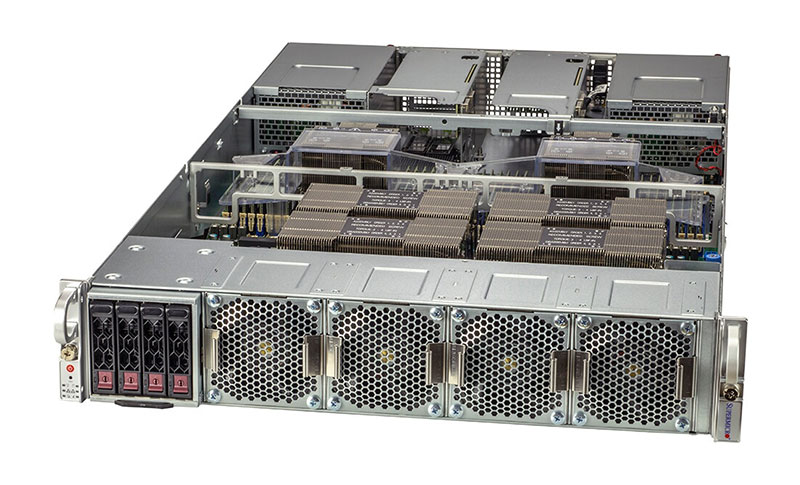

- 19" 2U Rackmount Chassis 4-way NVLINK GPUs

- Dual INTEL Xeon CPUs (up to 80-Cores)

- 1 TB DDR4 3200MHz ECC Memory (up to 4TB)

- HGX A100 4-GPU SXM4 80GB HBM2e NVLINK Multi-GPU Board 2039GB/s 400W

- 27,648 Total CUDA® Cores

- 1,728 Total Tensor Cores

- Up to 28 MIGs (Multi Instance GPUs) at 10GB each

- 2 x 1.92TB SATA SSD Disks

(up to 4 disks) - Ubuntu Linux 20.04 / 22.04 LTS

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- Anaconda Data Science Platform

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Infiniband HDR 200Gb/s Network for multi-node GPU Direct RDMA support

SuperNova Engine™ NA108 with NVLINK AM BESTEN

2,500 TFLOPS of Tensor Performance

156 TFLOPS of FP32 Performance

78 TFLOPS of FP64 Performance

5,000 TOPS of INT8 Tensor Performance

Am besten geeignet für:

Super-fast Multi-GPU Workloads

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Superschnelle Schlussfolgerung

Fordern Sie ein Angebot an

CNVAIS1-NA108V2

- 19" 4U Rackmount Chassis 8-way NVLINK GPUs

- Dual INTEL Xeon CPUs (up to 80-Cores)

- 2 TB DDR4 3200MHz ECC Memory (up to 4TB)

- HGX A100 8-GPU SXM4 80GB HBM2e NVLINK Multi-GPU Board 2039GB/s 400W-500W

- 55,296 Total CUDA® Cores

- 3,456 Total Tensor Cores

- Up to 56 MIGs (Multi Instance GPUs) at 10GB each

- 4 x 3.84TB NVMe Disks

(up to 10 disks) - Ubuntu Linux 20.04 / 22.04 LTS

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- Anaconda Data Science Platform

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Infiniband HDR 200Gb/s Network for multi-node GPU Direct RDMA support

Archivierte Produkte der CompecTA SuperNova™-Serie

Folgende Produkte können nicht mehr bestellt werden.

SuperNova Engine™ P100

74.8 TFLOPS of FP16 Performance

37.2 TFLOPS of FP32 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Gute Schlussfolgerung

NICHT VERFÜGBAR

CNVAIS1-P100V1

- 19" 1U Rackmount Chassis 4-way GPGPU

- Intel® Xeon® Processor E5-2697A v4

- 256 GB DDR4 2400MHz Memory

- 4 x NVIDIA Tesla P100 16GB HBM2 at 732 GB/s Memory

- 14,336 Total CUDA® Cores

- 4 x 512GB SSD Disks

(2 hot-swap and 2 fixed) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

Optional:

- Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

- Faster Intel® Xeon® Scalable Processors with DDR4 2666MHz memory

SuperNova Engine™ V100

448 TFLOPS of Tensor Performance

56 TFLOPS of FP32 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Schnelle Schlussfolgerung

NICHT VERFÜGBAR

CNVAIS1-V100V1

- 19" 1U Rackmount Chassis 4-way GPGPU

- Intel® Xeon® Processor E5-2697A v4

- 256 GB DDR4 2400MHz Memory

- 4 x NVIDIA Tesla V100 16GB HBM2 at 900 GB/s Memory

- 20,480 Total CUDA® Cores

- 2,560 Total Tensor Cores

- 4 x 512GB SSD Disks

(2 hot-swap and 2 fixed) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

- Faster Intel® Xeon® Scalable Processors with DDR4 2666MHz memory

SuperNova Engine™ NP104

84.8 TFLOPS of FP16 Performance

42.4 TFLOPS of FP32 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Gute Schlussfolgerung

NICHT VERFÜGBAR

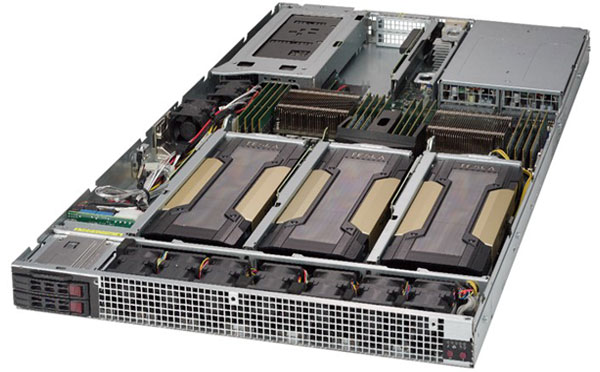

CNVAIS1-NP104V1

- 19" 1U Rackmount Chassis 4-way SXM2

- Intel® Xeon® Processor E5-2697A v4

- 512 GB DDR4 2400MHz Memory

- 4 x NVIDIA P100 SXM2 with NVLink 16GB HBM2 at 732 GB/s Memory

- Up to 80 GB/s GPU-to-GPU NVLINK

- 14,336 Total CUDA® Cores

- 4 x 512GB SSD Disks

(2 hot-swap and 2 fixed) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

Optional:

- Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

- Faster Intel® Xeon® Scalable Processors with DDR4 2666MHz memory

- One additional NVIDIA® Tesla P40 for Superschnelle Schlussfolgerung

SuperNova Engine™ NV104

500 TFLOPS of Tensor Performance

62.8 TFLOPS of FP32 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Superschnelles neuronales Netzwerktraining

Schnelle Schlussfolgerung

NICHT VERFÜGBAR

CNVAIS1-NV104V1

- 19" 1U Rackmount Chassis 4-way SXM2

- Intel® Xeon® Processor E5-2697A v4

- 512 GB DDR4 2400MHz Memory

- 4 x NVIDIA V100 SXM2 with NVLink 16GB HBM2 at 900 GB/s Memory

- Up to 300GB/s GPU-to-GPU NVLINK

- 20,480 Total CUDA® Cores

- 2,560 Total Tensor Cores

- 4 x 512GB SSD Disks

(2 hot-swap and 2 fixed) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

- Faster Intel® Xeon® Scalable Processors with DDR4 2666MHz memory

- One additional NVIDIA® Tesla P40 for Superschnelle Schlussfolgerung

SuperNova Engine™ NP108

170 TFLOPS of FP16 Performance

84.8 TFLOPS of FP32 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Ultra-Fast Training für neuronale Netze

Gute Schlussfolgerung

NICHT VERFÜGBAR

CNVAIS1-NP108V1

- 19" 4U Rackmount Chassis 8-way SXM2

- Intel® Xeon® Processor E5-2697A v4

- 512 GB DDR4 2400MHz Memory

- 8 x NVIDIA P100 SXM2 with NVLink 16GB HBM2 at 732 GB/s Memory

- Up to 80 GB/s GPU-to-GPU NVLINK

- 28,672 Total CUDA® Cores

- 4 x 512GB SSD Disks

(4 hot-swap) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

Optional:

- Up to 4 x Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

SuperNova Engine™ NV108

1000 TFLOPS of Tensor Performance

125.6 TFLOPS of FP32 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Ultra-Fast Training für neuronale Netze

Schnelle Schlussfolgerung

NICHT VERFÜGBAR

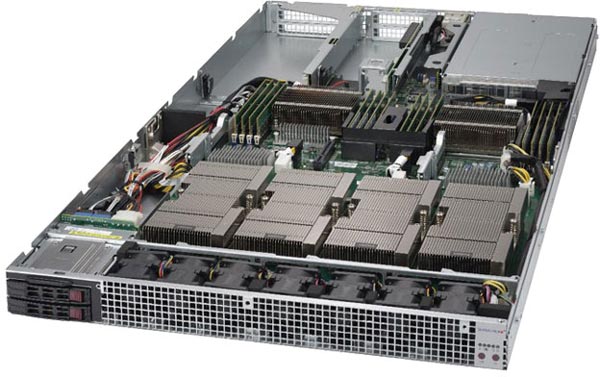

CNVAIS1-NV108V1

- 19" 4U Rackmount Chassis 8-way SXM2

- Intel® Xeon® Processor E5-2697A v4

- 512 GB DDR4 2400MHz Memory

- 8 x NVIDIA V100 SXM2 with NVLink 16GB HBM2 at 900 GB/s Memory

- Up to 300GB/s GPU-to-GPU NVLINK

- 40,960 Total CUDA® Cores

- 5,120 Total Tensor Cores

- 4 x 512GB SSD Disks

(4 hot-swap) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Up to 4 x Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

SuperNova Engine™ P40

48 TFLOPS of FP32 Performance

188 TOPS of INT8 Performance

Am besten geeignet für:

Deep-Learning-Entwicklung

Gutes Training für neuronale Netze

Superschnelle Schlussfolgerung

NICHT VERFÜGBAR

CNVAIS1-P40V1

- 19" 1U Rackmount Chassis 4-way GPGPU

- Intel® Xeon® Processor E5-2697A v4

- 256 GB DDR4 2400MHz Memory

- 4 x NVIDIA Tesla P40 24GB Memory

- 15,360 Total CUDA® Cores

- 4 x 512GB SSD Disks

(2 hot-swap and 2 fixed) - Ubuntu 14.04 / 16.04

- NVIDIA-qualified driver

- NVIDIA® DIGITS™

- NVIDIA® CUDA® Toolkit

- NVIDIA® cuDNN™

- Caffe, Theano, Torch, BIDMach

- 100.000 CPU-Zeit auf FeynmanGrid™

- CompecTA® Enterprise Support und HPC Professional Services – 1 Jahr

- Mellanox EDR 100Gb/s or FDR 56Gb/s Infiniband for GPU Direct RDMA

- Faster Intel® Xeon® Scalable Processors with DDR4 2666MHz memory

Mehr Informationen erhalten!

Unsere Experten können all Ihre Fragen beantworten. Bitte erreichen Sie uns per Mail oder Telefon.

TÜRKÇE

TÜRKÇE ENGLISH

ENGLISH DEUTSCH

DEUTSCH